주어진 텍스트에서 용도에 맞게 토큰을 분류하는 작업을 토큰화(tokenization)라고 하며, 토큰화 작업 전, 후에는

텍스트 데이터를 용도에 맞게 정제(cleaning) 및 정규화(normalization)하는 일이 항상 함께한다.

1. 정제(Cleaning)란?

정제는 주어진 텍스트에서 노이즈 데이터를 제거하는 것을 말한다.

노이즈 데이터란 자연어가 아니면서 아무 의미도 갖지 않는 글자들(특수 문자 등)을 의미하기도 하지만,

분석하고자 하는 목적에 맞지 않는 불필요 단어들을 말하기도 한다.

불필요 단어들을 제거하는 방법으로는 불용어 제거와 등장 빈도가 적은 단어, 길이가 짧은 단어들을 제거하는 방법이 있다.

2. 불용어(Stopword) 제거

불용어는 의미 없는 특수문자 들과는 별도로, 실게 사용되는 단어이지만 분석에는 별 필요가 없는 단어들을 말한다.

예를 들어 I, my, me, over, 조사, 접미사 같은 단어들을 말하며, NLTK에서는 100여개 이상의 영어 단어들을

불용어로 패키지 내에서 미리 정의하고 있다.

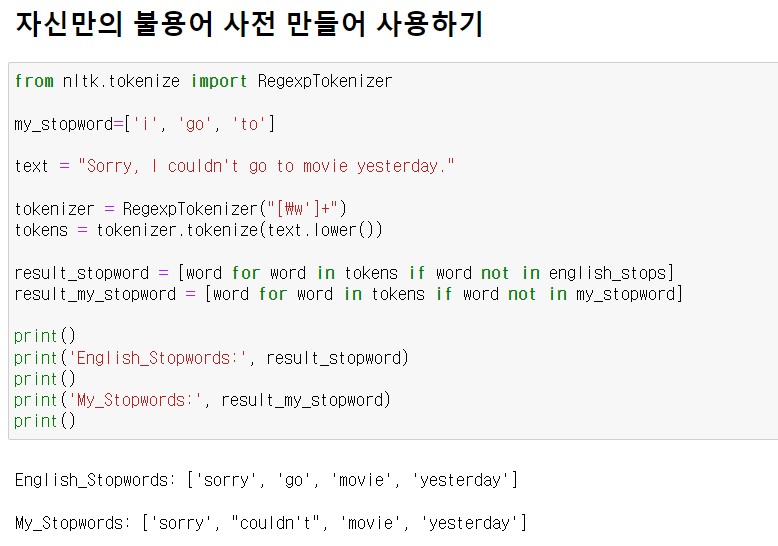

또한, 사용자가 불용어 사전을 만들어서 사용할 수도 있다.

나의 불용어 사전에는 'i', 'go', 'to' 를 넣었다. 그래서 NLTK 불용어 패키지를 사용했을때의 결과는

'go'를 포함하고 있지만 나의 불용어 사전을 사용했을때의 결과에는 'go'를 포함하고 있지 않다.

반대로 NLTK 불용어 사전에는 "couldn't"가 불용어로 되어있어서 결과에 나오지 않았는데

나의 불용어 사전에는 "couldn't"가 불용어로 포함 되어있지 않기 때문에 결과에 "couldn't"가 포함됐다.

REFERENCE

파이썬 텍스트 마이닝 완벽 가이드(2022)

'데이터 분석 > 자연어 처리' 카테고리의 다른 글

| 2.6 문서 단어 행렬(Document-Term Matrix, DTM) (1) | 2023.01.19 |

|---|---|

| 2.5 Bag of Words(BoW) (0) | 2023.01.16 |

| 2.4 품사 태깅(PoS Tagging) (0) | 2023.01.10 |

| 2.3 정규화(Nomalization) (0) | 2023.01.09 |

| 2.2 토큰화(Tokenization) (0) | 2023.01.09 |